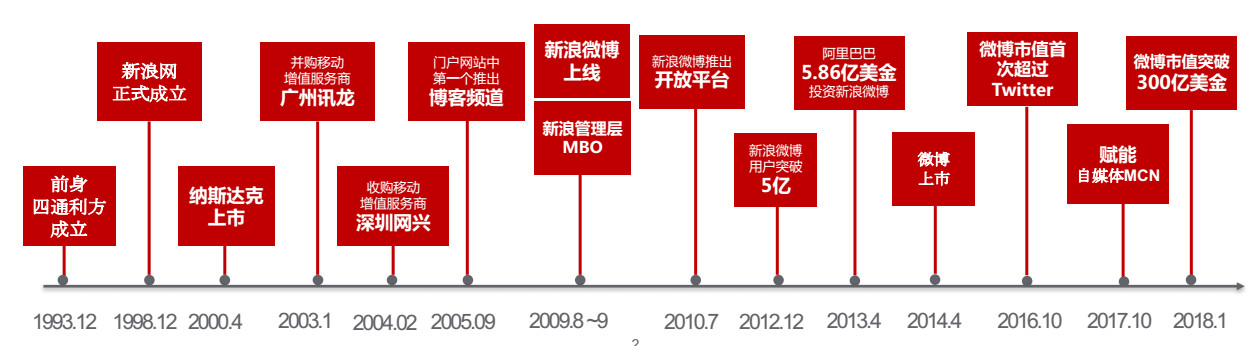

<新浪大数据体系奠基>

2008年前后,新浪开启了重要的数据探索之旅。那个时候,新浪着手搭建Hadoop集群,并且建立信息系统用于收集公司级基础数据。这一举动犹如给之后的大数据发展打了一剂强心针,为大数据系统筑牢了根基。这些基础数据的收集为后续更复杂的数据处理和利用做好了准备。

<微博兴起与业务数据积累>

2009年之后,微博逐渐在互联网崭露头角。随着微博的发展,越来越多的用户参与进来,产生了海量的内容和行为数据。新浪信息流开户客服积极解决业务数据处理的问题,这些数据为大数据的业务数据和业务场景提供了丰富的基础素材,让新浪在数据领域有了更强的竞争力,业务发展有了更多可能性。

<微博开放平台的数据交流>

2011年到2012年间,微博开放平台的推出是一个重要的节点。它让微博数据和第三方数据能够相互交流,打破了数据之间的壁垒。这种数据的流动和交换促进了数据的多元化和丰富性,也为各类创新业务的开展提供了新的契机,新浪在数据领域的影响力进一步扩大。

<大数据达尔文平台搭建>

2013 - 2014年,新浪成功搭建了大数据达尔文平台。该平台承担着梳理挖掘用户数据和行为数据的重任。通过这个平台,新浪能够描绘微博用户的画像,还能分析理解微博短文本,形成内容标签等内容理解系统,这为精准推送和用户个性化服务奠定了基础。

<实时流计算技术引入>

与此同时,新浪引入了基于分布式离线处理的实时流计算。这项技术让数据能够更快地发挥作用价值,数据就像是有了加速度一样,能及时应用到企业服务中。它可以让企业更快地根据数据做出决策,满足用户的实时需求,增强了企业的服务能力和竞争力。

<应对技术挑战的举措>

实时流计算技术有挑战,大规模机器学习和深度学习技术更是如此。为应对这些问题,新浪一方面深化与阿里云合作,引入数字 +、EMR、HPC、Pai等成熟系统加快发展。另一方面,依托开源社区自主研发,完善参数服务器weips和机器学习编程框架weiflow,以满足平台业务需求,不断提升自己的技术实力。

<人工智能技术集成>

人工智能技术让微博的离线、实时和在线系统集成得更紧密。在线系统为机器学习提供样本数据,离线训练的模型应用到业务系统中,实时系统还能提供在线培训服务,保证功能和模型的及时性,进而确保业务效果。这就像一个完整且高效的机器,各个部分紧密配合,让微博运营更高效。

<信息流的机器学习应用>

以微博 feed 信息流为例,在掌握内容数据和用户画像的基础上,采用大规模机器学习模型排序。它可以控制低质量内容,挖掘用户感兴趣的个性化内容,大大提高了微博信息流的用户体验,让用户能看到更符合自己需求的内容,增强用户对微博的粘性。

<机器学习实验室探索>

微博专门设立的机器学习实验室专注于深入研究人工智能技术的潜在应用价值。其实验室研究项目广泛,涵盖机器学习算法、推荐算法等多个方面。其实验室的使命就是把技术价值体现在微博业务中,不断推进技术创新和业务发展。

你觉得微博在大数据和人工智能技术方面的未来发展会有哪些新突破?希望大家点赞分享并留言评论!