微博广告Hubble系统在当今的互联网广告领域具有极大的价值。面对微博广告业务迅速增长所带来的复杂系统管理挑战,它是如何通过架构实践脱颖而出的?这成为了人们关注的焦点。

业务驱动监控需求

在微博业务快速增长的大背景下,计算广告系统愈发复杂。众多的模块进行着计算和通信,广告系统包含如智能流量分发、投放结算等多种功能。在2022年时,其系统复杂度已经达到了管理成千上万模块的程度。如此庞大的体系,保证系统正常运行很困难,这就急需像Hubble这样的监控平台。Hubble平台每日要处理的监控数据达到了TB级别,报警规则也有万级。这从侧面表明微博广告业务规模之大,从而凸显出Hubble平台的重要性。

而微博广告业务不断发展,对Hubble平台的需求也更高。例如随着新产品的推出,需要Hubble平台更加精密地监控,以适应新业务逻辑下的服务器和系统保驾护航需求。

平台化视角下的监控

从平台化的角度看,监控报警平台要解决一系列问题。比如说要能统一管理众多的监控设备与目标。在微博广告系统内,物质资源非常多,包括不同类型的服务器等。需要监控平台能够整合这些不同资源下的监控信息。而且平台对于数据收集要做到全面、高效。曾经有过因为平台在某一时期数据收集不全面,导致部分广告投放异常没有及时监测到,影响了客户体验。

还有很重要的一点是平台化的监控要便于管理和维护。在微博内部,技术人员会定时评估监控平台的管理和维护工作。曾经的旧监控平台,维护起来特别麻烦,需耗费大量人力。而Hubble系统就致力于在这方面进行改善,力求使用尽量少的人力去维护整个平台的正常运转。

业务视角看智能监控

从业务视角考虑,监控报警平台的核心问题有很多。首先要能及时反映业务健康状况。在微博里,每天广告业务量都不同,特定的节日或者活动期间会大幅增长。这时候如果监控平台不能及时反映业务健康状况,例如在“双十一”期间,可能很多广告投放效果变低,如果监控平台没有发现,就会对业务产生影响。

再者就是要结合业务流程来定制监控。微博广告业务有自己独特的业务流程,从客户下单到广告投放再到效果反馈。每一个环节都需要监控与之配合。比如说,从数据看下单客户量很少,这时就需要监控来查找是哪个环节出了问题,是前台广告展示不吸引客户还是后台业务对接有问题等。

系统架构构建监控体系

从系统架构及设计视角考虑,监控报警平台要解决多方面的问题。它要能够处理大规模数据,微博广告的数据量非常大,有海量的投放数据等。之前的监控系统在处理大规模数据时存在卡顿现象。Hubble系统则基于D+大数据技术来构建自己的体系,使得可以高效处理数据。

系统还得具有可扩展性。随着微博广告业务的拓展,会有更多的模块加入。例如新加入的一些国外业务拓展模块,系统必须要能很好地融入这些新东西。在2023年微博向部分国外市场拓展广告业务时,Hubble系统的可扩展性就得到了考验,还好它有良好的架构,可以轻松接入新业务模块。

机器学习助力Hubble

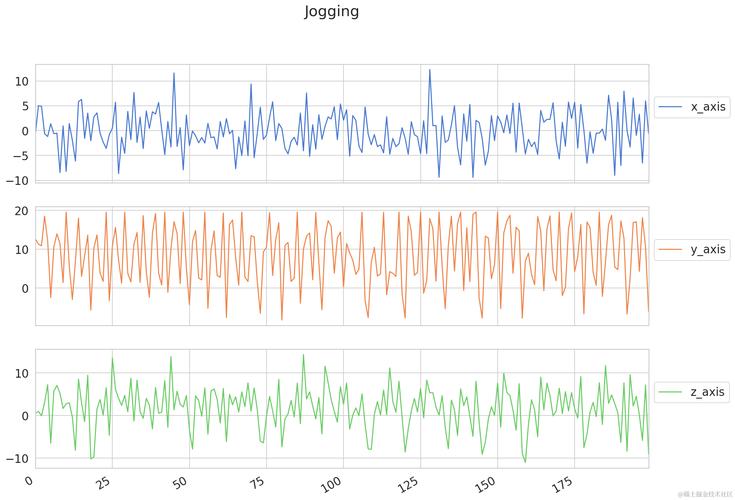

Hubble平台利用机器学习技术进行趋势预测和报警阈值的智能调整。其中的LSTM在处理时间序列数据方面有着非凡的表现。例如在预测广告投放量的走势时,如果只依靠传统的方法,误差会较大。而LSTM可以更精准地预测,这得益于它对历史数据的有效学习。

Tensorflow框架也为机器学习在Hubble平台应用提供了支持。技术人员可以利用Tensorflow便捷地构建模型,以适配各种监控业务。当要做万级别报警规则下的智能报警阈值调整时,基于Tensorflow搭建的模型就可以快速运算,大大提高了监控的效率。

监控未来发展之思考

Hubble系统还有很多可以发展的方向。在数据安全性方面要不断加强,由于微博广告业务涉及到众多企业客户的商业信息。2024年预计微博广告业务会扩大一倍,那时侯数据的安全性要求会更高。

同时,如何进一步优化机器学习算法以提升监控效果也是需要考虑的点。可以借鉴其他领域最新的人工智能成果,不断融入到Hubble系统中,让其对广告系统的监控更加智能、精准。

你觉得微博广告Hubble系统在未来还会面临哪些挑战?希望你能在评论区留言,如果你觉得这篇文章不错,也欢迎点赞和分享。