谁能想到,看似热闹欢快的春晚红包活动背后,是互联网大厂们惊心动魄的技术较量!一直以来,春晚活动技术上多是 BAT 当家,这次快手强势入局,究竟经历了什么?下面就一起来看看。

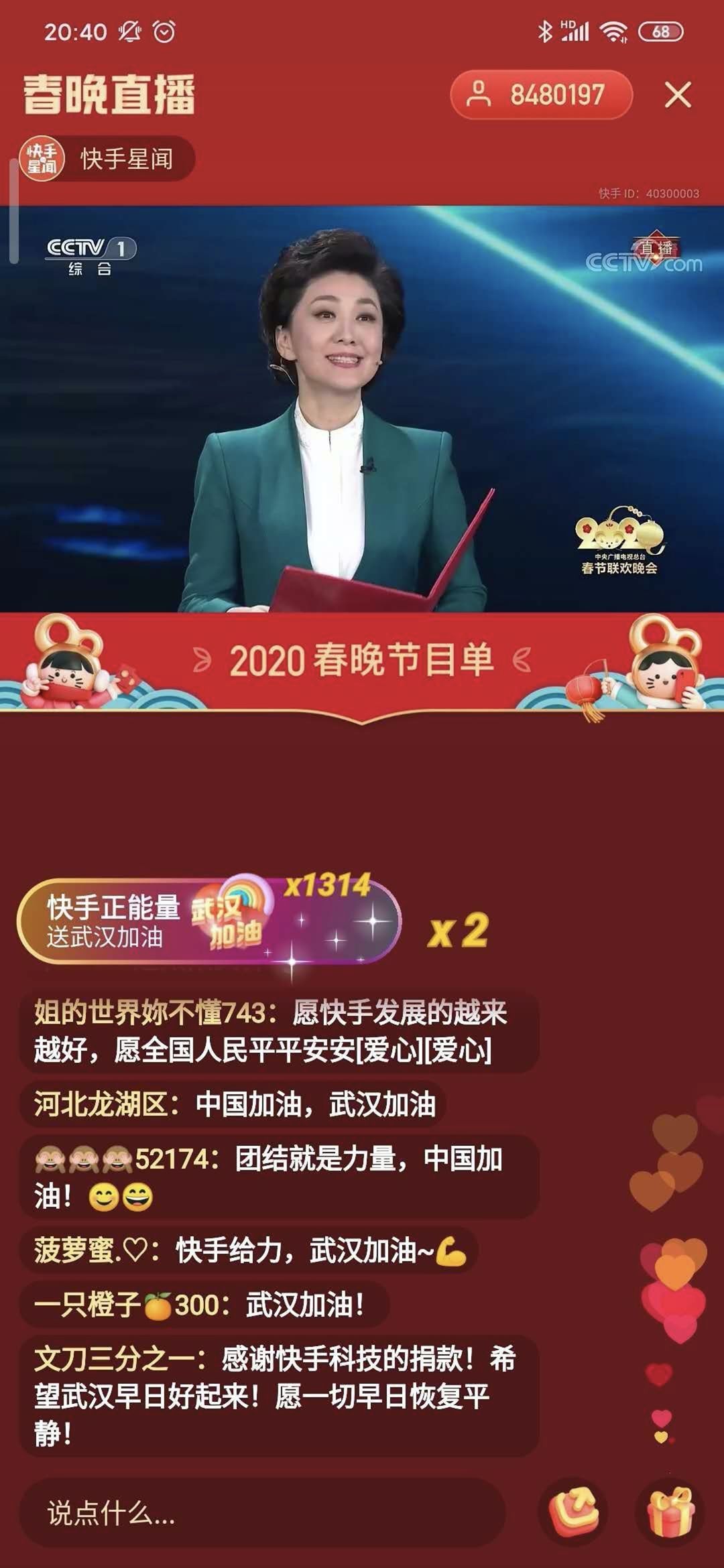

紧急上线捐赠功能

除夕前一天,严峻的疫情牵动着每个人的心。快手技术团队紧急行动起来,在春晚红包活动提现环节快速开发上线“助力武汉”红包捐赠功能。可以想象当时的时间多么紧迫,在这么关键的时刻马上完成开发,团队成员肯定付出了无数心血通宵达旦工作,才让公益在这个特殊时刻能顺利融入到活动中。

服务器资源储备

基于短视频业务特点,它对服务器等基础资源的要求可不低。据推测,快手为了这次春晚活动准备的服务器数量不会少于百度。毕竟要应对春晚这般的高并发流量,没有充足的服务器支撑怎么行。大量服务器严阵以待,就是为了保障活动期间用户使用的流畅。

CDN 解决方案

在短视频领域,内容分发网络(CDN)是个惯用的好办法。快手也用这个策略,把视频文件输送到离用户最近的地方,利用大量 CDN 节点分担用户观看流量。这可是业界成熟方案,能让用户更快更稳地看到视频内容,为活动奠定了很好的基础。

流量洪峰挑战

春晚活动开启时,那场景实在太震撼了。数亿用户同时启动快手 App,带来的流量洪峰就像汹涌的洪水。如果不做降级处理,服务器很可能就被冲垮了。团队面临的挑战就是要让用户顺利“进门”抢红包,而不是被宕机的服务器拒之门外。这个任务难度可想而知。

系统细节优化

从客户端到服务器,团队做了几十项优化。为了就是让用户能“秒登”快手 App,顺利拿到红包。在发钱环节更是对系统要求极高,几十分钟内发出 10 亿现金,还不能有 bug。架构上团队精心设计,像保证核心操作的幂等性、多维度预算控制、多种熔断检查、根据流量动态调度发钱速度等,每个细节都不放过。

应用市场保障

应用市场就像是春晚活动的大门,要是新安装用户在这一步卡住进不来,那后续红包活动就没机会参与了。快手专门有团队和第三方应用市场沟通,几乎把应用商店这次会用到的技术全面盘点了一遍。还把自研的曲线拟合技术背后的数据和逻辑共享给应用商店。团队不仅分资源、给人手,还给出完整活动逻辑方案,全方位保障应用市场不出问题。

快手这场春晚技术大考,面对这么多难题都努力克服。你认为哪家互联网大厂在春晚活动的技术表现最让你印象深刻?如果你觉得本文有用,就点赞分享!